Open Interpreter的搭建与使用

Open Interpreter的搭建与使用

项目地址:https://github.com/KillianLucas/open-interpreter

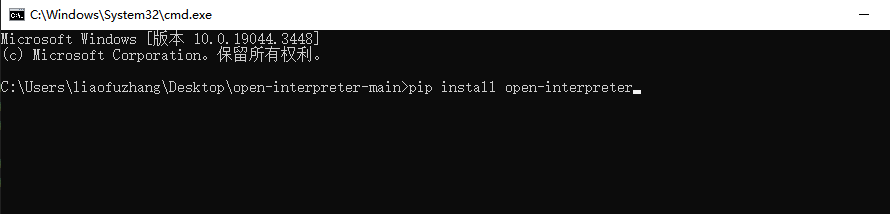

项目依赖下载:pip install open-interpreter

使用命令窗口CD到项目路径下使用命令下载依赖

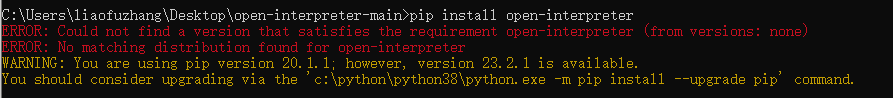

需要注意的是下载依赖pip版本需要在23.2.1及以上

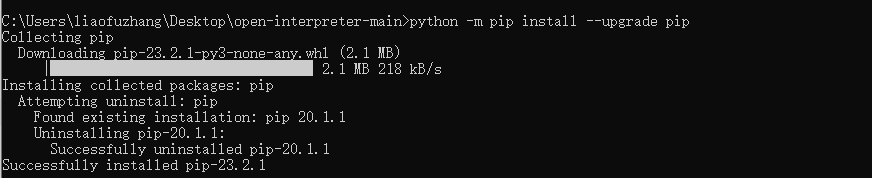

执行如下命令将pip升级至最新版

python -m pip install --upgrade pip

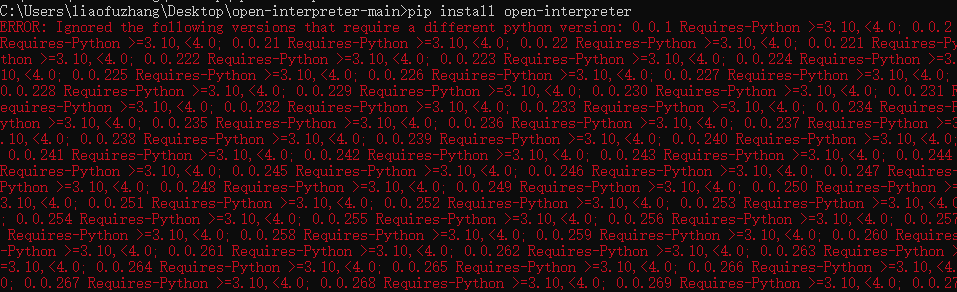

安装时报如下错误表示Python版本过低(项目运行需要Python3.10及以上)

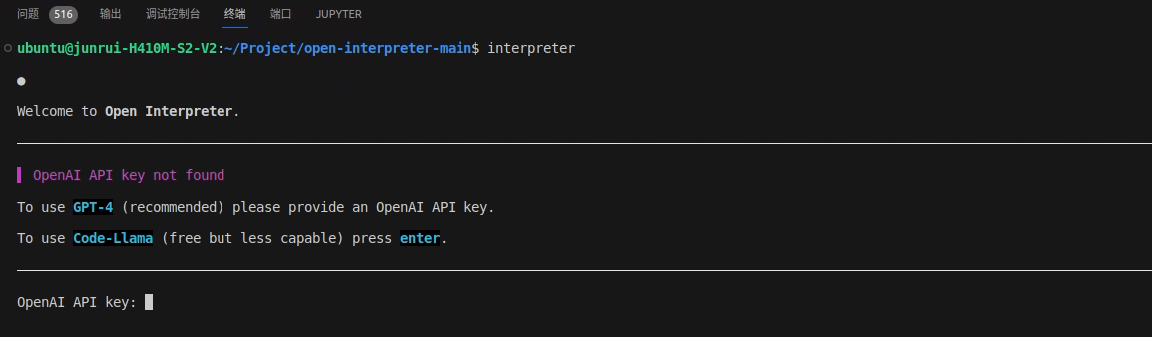

在命令终端进入到项目根目录,输入interpreter运行启动项目。

本项目有以下两种运行模式

1、使用ChatGPT-4的模型

2、使用本地模型

如选择使用在线ChatGPT模型,输入OpenAI Key(需要拥有GPT-4权限的API Key)

interpreter

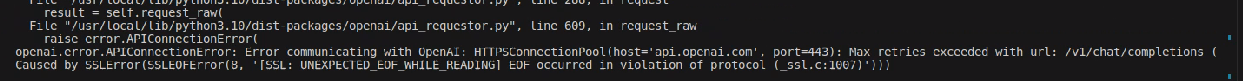

使用GPT3.5的api key会报错如下:

openai.error.InvalidRequestError: The model gpt-4 does not exist or you do not have access to it. Learn more: https://help.openai.com/en/articles/7102672-how-can-i-access-gpt-4

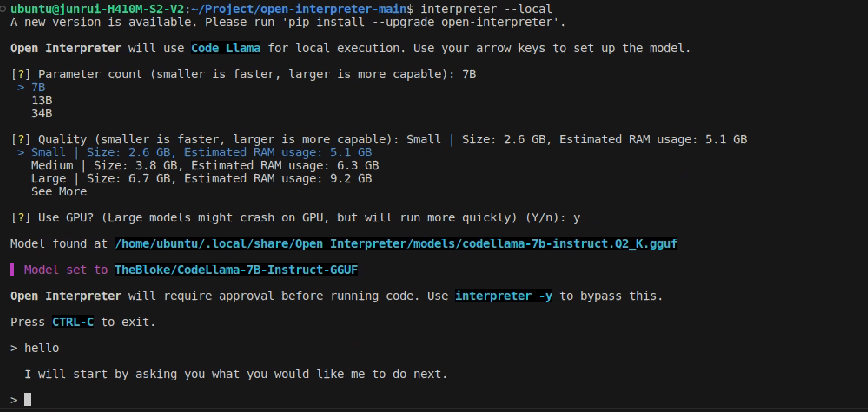

如选择使用本地CodeLlama模型,输入以下命令

interpreter --local

选择下载需要的模型大小,下载完成后即可使用【由于模型较大,下载过程中经常会由于网络波动停止下载,只需重新执行上面的操作,选择上一次下载中断的模型即可继续下载】

测试例子:

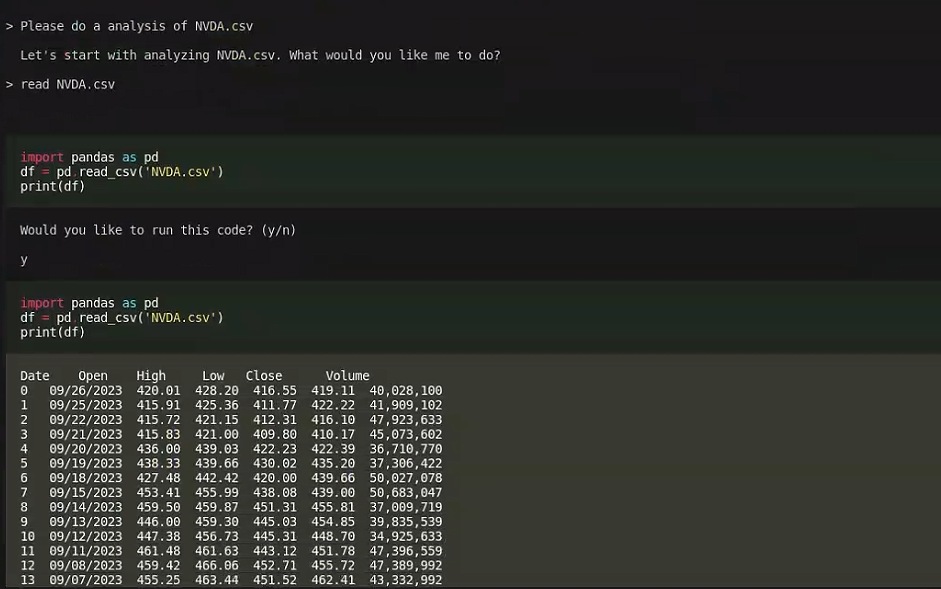

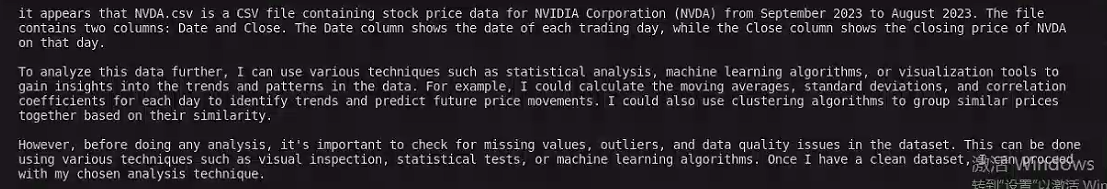

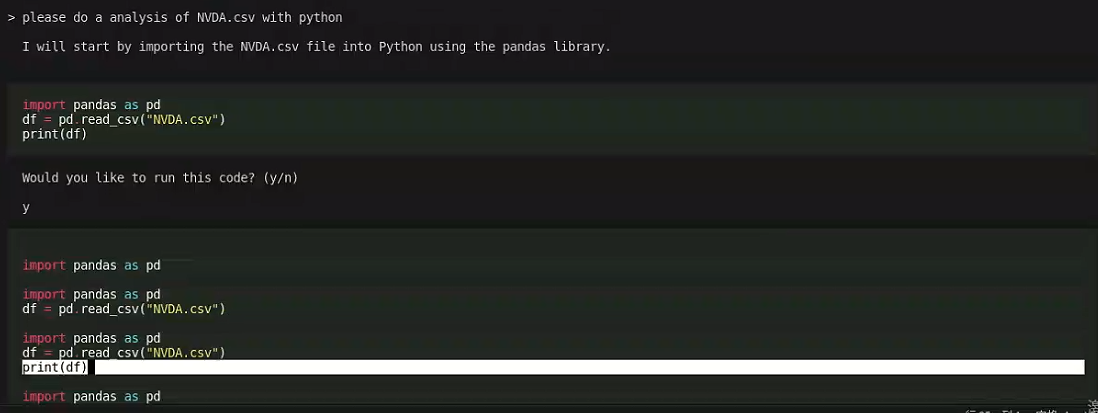

将NVDA.csv文件放到项目的根目录,让本地模型对文件进行数据分析,简单地读取了NVDA.csv文件没有出现问题

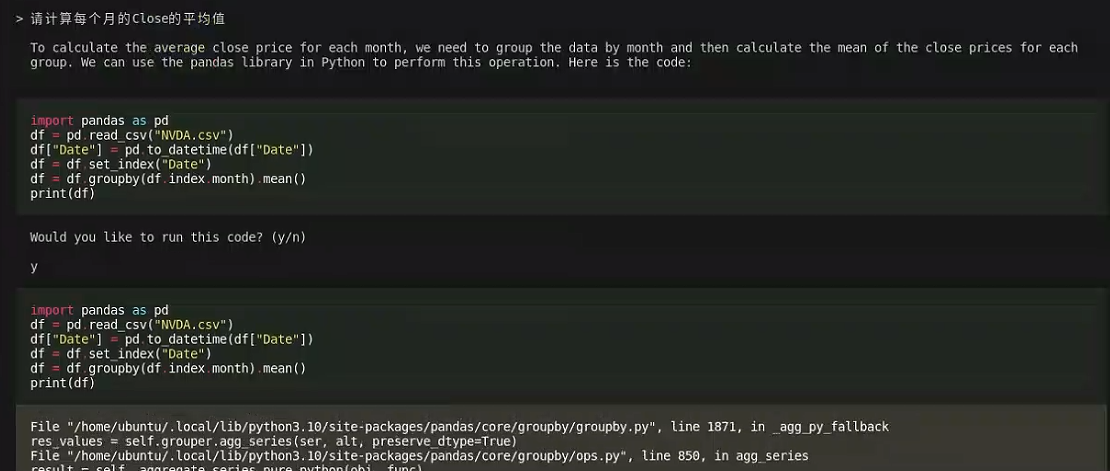

但是让它进行相关分析时,和ChatGPT一样会给出一些错误的代码执行后报错。

问题:Please do a analysis of NVDA.csv

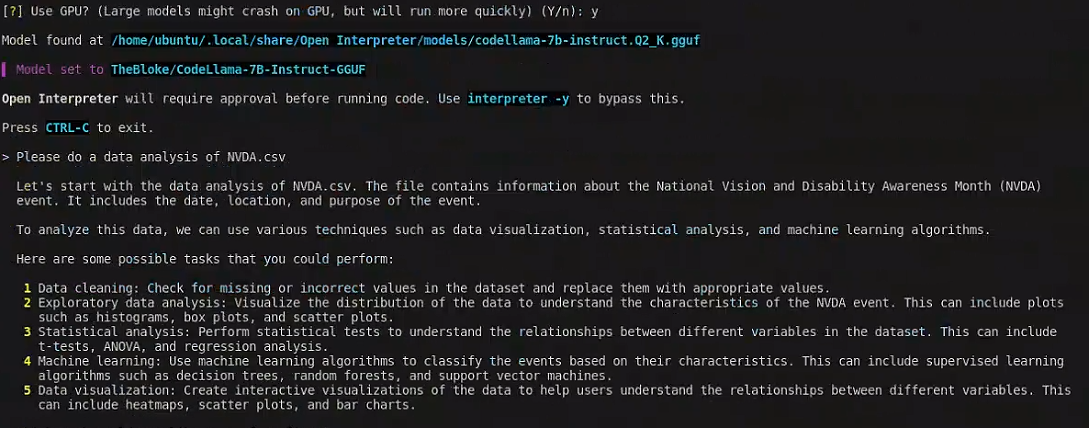

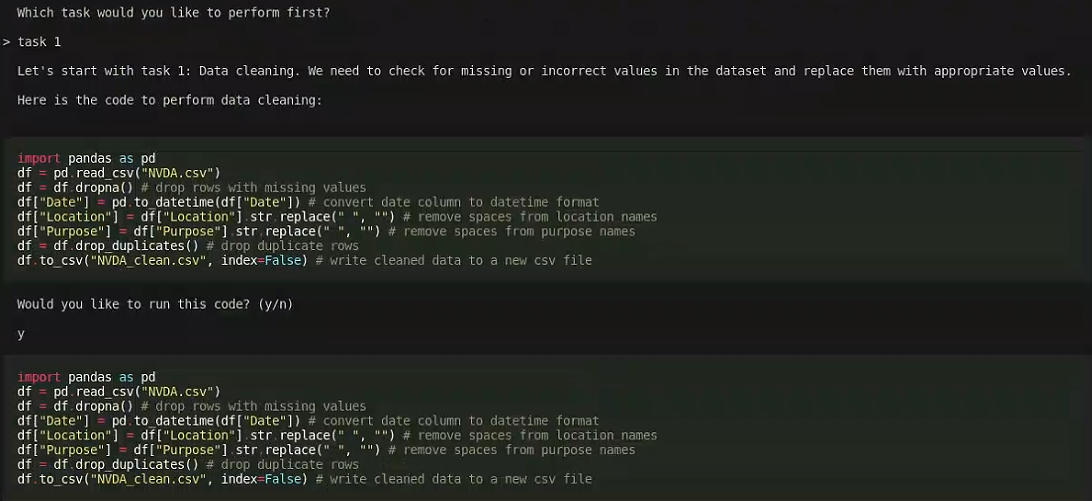

给出了一些数据分析的步骤供我们选择,这里选择了task 1 数据清洗

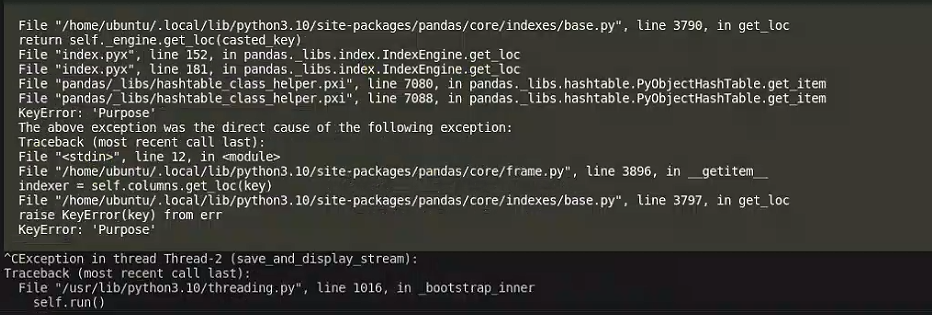

Open Interpreter给出了一些代码,执行后报错。列名找不到,表示模型在读取文件的准确性还不行。

性能评价和应用前景收集

测试使用的模型是本地模型,相关选项如下

[?] Parameter count (smaller is faster, larger is more capable): 7B

7B

13B

34B

[?] Quality (smaller is faster, larger is more capable): Small | Size: 2.6 GB, Estimated RAM usage: 5.1 GB

Small | Size: 2.6 GB, Estimated RAM usage: 5.1 GB

Medium | Size: 3.8 GB, Estimated RAM usage: 6.3 GB

Large | Size: 6.7 GB, Estimated RAM usage: 9.2 GB

See More

[?] Use GPU? (Large models might crash on GPU, but will run more quickly) (Y/n): y

本地模型的响应时间较长,对于提问的问题回答有时会胡编乱造。不停输出相同的内容。

使用中文提问响应时间漫长,且容易出错。

问题:

是不是比较依靠chatgpt,而跟其他模型,如chatGLM2没有延展性的可能?

这个项目有本地模型运行和线上ChatGPT两种模式,线上是基于ChatGPT-4 的api key进行的,需要较高的费用。本地模型运行则需要自身服务器的GPU显存及内存容量较大,足以支撑模型的运行才行。本项目中本地模型有可供的三种大小的模型选择。选择本地模型运行则无需依靠ChatGPT,没有额外的收费。

但本项目中无论是线上还是本地模型,都没有提供模型微调的功能,仅仅只是调用了现有的模型进行提问和实现相关功能。对于下载的本地模型的投喂数据、模型微调需要单独地去研究。

更新:

由于项目的更新,如今Open Interpreter项目可以使用的模型有多种

1、本地模型

2、项目可切换的模型

3.5模型:interpreter --model gpt-3.5-turbo 4.0模型:interpreter

Code Llama:interpreter --local

根据HuggingFace 的 repo ID(如 “tiiuae/falcon-180B”)来本地运行任何 HuggingFace 模型:

interpreter --model tiiuae/falcon-180B

更多详细信息官方文档地址:

open-interpreter/README_ZH.md at main · KillianLucas/open-interpreter (github.com)